AI ristretta, AGI e Superintelligenza – differenze, sfide e scenari futuri

- Definizione dell’intelligenza artificiale

- Perché distinguere tra ristretta, generale e super-AI

- AI Ristretta (Narrow AI)

- AI Generale (AGI)

- Superintelligenza (ASI)

- Confronto tra le tre tipologie di AI

- Conclusioni

- Faq

Definizione dell’intelligenza artificiale

Quando parliamo di IA ci riferiamo a sistemi in grado di compiere funzioni che, fino a poco tempo fa, richiedevano competenze tipiche dell’uomo: riconoscere pattern complessi, estrarre significati da segnali rumorosi, apprendere da esperienze pregresse, ragionare a partire da premesse incomplete. In pratica, si tratta di una galassia di metodi — simbolici, statistici, neurali — che convergono verso un medesimo obiettivo: estendere o sostituire parti dell’attività cognitiva umana attraverso procedure eseguite da macchine.Perché distinguere tra ristretta, generale e super-AI

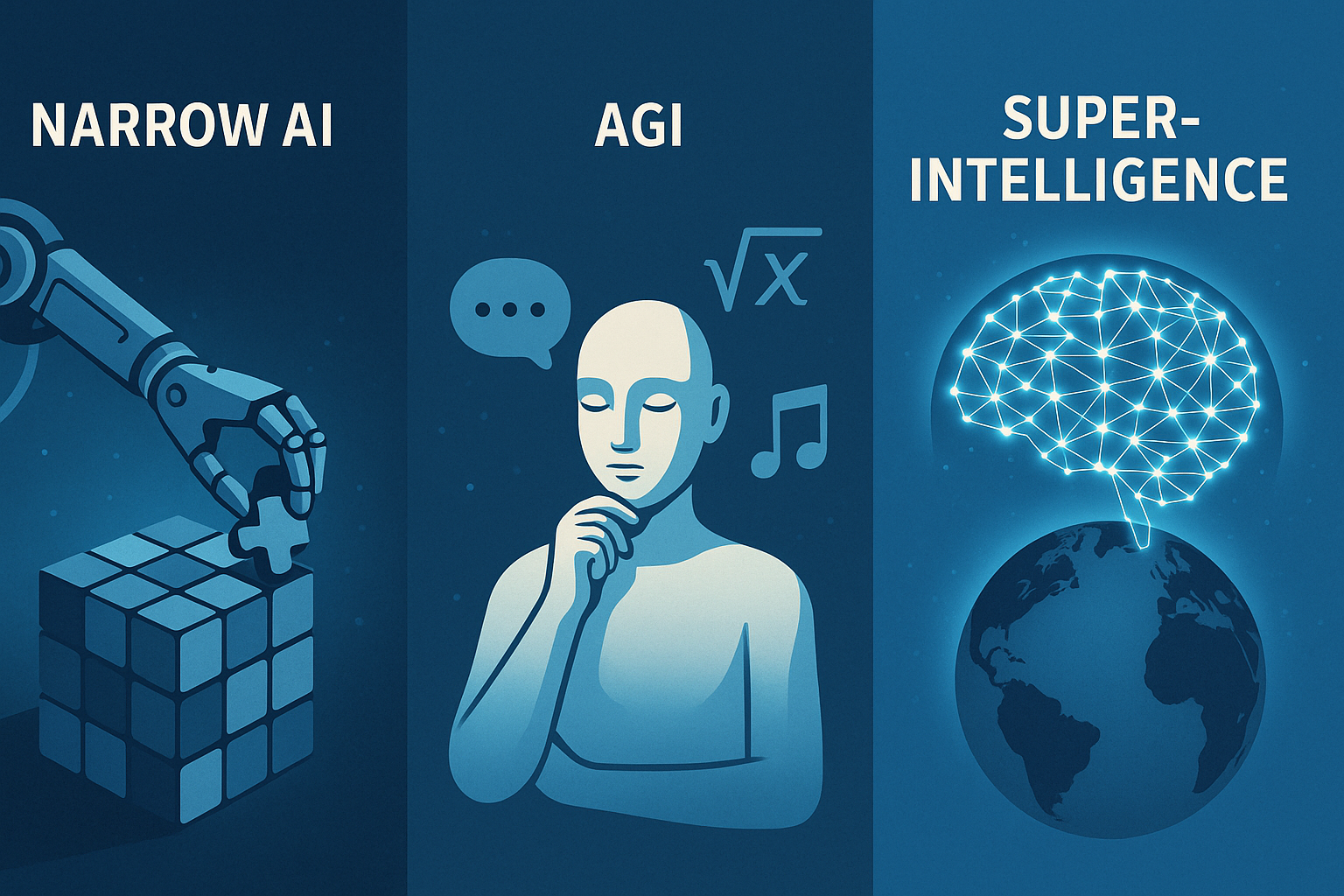

La differenziazione non è una mera finezza terminologica. Stabilire a quale categoria appartenga un sistema permette di misurare con maggiore precisione aspettative, benefici e rischi. Un assistente vocale che imposta il timer della pasta opera in un contesto radicalmente diverso da un algoritmo che decide la strategia terapeutica per un paziente oncologico, mentre un’ipotetica superintelligenza che sovrasta la mente umana in ogni disciplina configurerebbe uno scenario di discontinuità storica. Comprendere la posizione di ciascuna tecnologia lungo questo spettro è quindi indispensabile per chi formula policy, per chi investe capitali e, più in generale, per qualunque cittadino desideri orientarsi nel dibattito pubblico.

AI Ristretta (Narrow AI)

La prima proprietà che balza all’occhio è la specializzazione. Un algoritmo di visione artificiale addestrato a riconoscere lesioni dermatologiche può superare la media dei dermatologi umani, ma resta del tutto ignaro di cosa sia una polizza assicurativa o un argomento di logica formale. La seconda caratteristica è la dipendenza dai dati: il comportamento del modello è una funzione estremamente sensibile al volume, alla qualità e alla rappresentatività dei campioni di addestramento. Da qui discende un limite importante, la fragile capacità di generalizzazione. Piccole variazioni dell’ambiente, per esempio un’illuminazione diversa o uno slang regionale nei comandi vocali, possono generare errori macroscopici. Inoltre i modelli ristretti non posseggono consapevolezza delle ragioni che sottendono alle loro conclusioni. Anche quando forniscono una spiegazione, questa è spesso un post-hoc costruito su metriche di importanza dei dati: utile per l’audit, ma lontano dal ragionamento causale umano. Il ventaglio di utilizzi concreti è ampio e in continua espansione. Gli assistenti vocali sfruttano catene di modelli che vanno dal riconoscimento del parlato alla comprensione semantica, fino alla gestione del dialogo. Nei servizi di streaming, gli algoritmi di raccomandazione filtrano cataloghi sterminati in tempo reale, apprendendo dai comportamenti di milioni di utenti. Sulle linee di montaggio, sistemi di visione guidano bracci robotici nell’individuare difetti che sfuggirebbero all’occhio umano, mentre negli ospedali reti neurali convoluzionali analizzano radiografie e tomografie con una velocità che consente triage quasi istantanei. La finanza ad alta frequenza offre un altro esempio eloquente: micro-strategie di trading vengono eseguite in millisecondi da agenti che anticipano variazioni di prezzo impercettibili all’investitore tradizionale. La stessa medicina preventiva si avvale di modelli predittivi in grado di segnalare anomalie cardiache o metaboliche ore, se non giorni, prima che si manifestino sintomi clinici. Questi successi, tuttavia, non vanno letti come segnali di un’intelligenza onnicomprensiva, bensì come dimostrazione di quanto la potenza statistica, applicata a domini stretti, possa raggiungere performance sovrumane e al contempo rimanere totalmente avulsa da comprensione contestuale. A livello di robustezza, la Narrow AI soffre della cosiddetta brittleness. Un leggero disturbo aggiunto ai pixel di un segnale visivo, impercettibile all’occhio, può ingannare il classificatore. Similmente, un documento contenente frasi grammaticalmente corrette ma semanticamente fuorvianti può indurre un modello linguistico a conclusioni sbagliate e potenzialmente pericolose in ambito legale o sanitario. L’elaborazione simbolica, che pure aveva dominato la prima era dell’IA, risulta difficile da integrare con i modelli di apprendimento profondo; di conseguenza, la capacità di ragionare per cause ed effetti resta limitata. Un’altra barriera è il costo energetico. Addestrare un modello di grande taglia può consumare energia quanto centinaia di famiglie in un anno, con un’impronta di carbonio che contraddice l’ideale di sostenibilità digitale. Infine, la difficoltà di trasferire competenze da un contesto a un altro genera costi di sviluppo separati per ogni nuovo dominio, rallentando la scalabilità economica rispetto alle promesse iniziali.AI Generale (AGI)

Il termine AGI indica un sistema capace di replicare, in linea di principio, l’intero spettro delle competenze cognitive umane. Non si tratta di eguagliare l’uomo in ogni singolo compito, bensì di possedere la flessibilità di apprendere concetti astratti, di ragionare su base causale, di trasferire analogie da un dominio a un altro mantenendo solidità logica. L’obiettivo dichiarato dai laboratori che inseguono l’AGI è concepire macchine che, ricevendo obiettivi di alto livello, possano elaborare piani d’azione creativi e adattivi, aggiornando i propri modelli mentali in modo continuo, proprio come una persona che maturi esperienza nel tempo. Rispetto alla Narrow AI, l’AGI si discosta anzitutto per il concetto di dominio. Un agente generale deve muoversi tra compiti eterogenei senza dover essere ri-addestrato da zero. La stessa nozione di “dato di training” cambia: all’AGI si richiederebbe di estrarre regole latenti dalla semplice osservazione del mondo, analogamente a un bambino che costruisce un modello del linguaggio prima ancora di imparare a leggere. Un aspetto cruciale è l’autonomia decisionale. Il sistema non attende una lista puntuale di istruzioni, ma interpreta obiettivi ambigui, colma lacune informative e, se necessario, definisce sotto-obiettivi intermedi. Questa autonomia entra in tensione con il bisogno di controllo degli sviluppatori, definendo la sfida del cosiddetto “allineamento”, cioè la garanzia che gli scopi dell’AGI restino compatibili con i valori umani, anche quando l’agente auto-migliora le proprie capacità. Il cammino verso l’AGI incrocia ostacoli di natura tecnica, filosofica ed economica. Sul fronte tecnico manca un’architettura di riferimento che integri in modo fluido memoria a lungo termine, pianificazione simbolica e apprendimento neurale. Inoltre, i sistemi attuali rimangono quantitativamente voraci: l’analogia con il cervello umano evidenzia un divario drastico tra il consumo di 20 watt di un organo biologico e i megawatt richiesti da data center su scala planetaria. A livello filosofico, l’AGI riapre il dibattito sulla coscienza artificiale. Se un sistema sviluppasse auto-consapevolezza, quali diritti morali gli spetterebbero? Al tempo stesso, se la coscienza non sorgesse, l’AGI potrebbe comunque simulare emozioni e convincerci di possederne, con ricadute etiche che richiedono nuovi paradigmi giuridici. Sul versante economico, la realizzazione di un’AGI comporterebbe la ristrutturazione dell’intero mercato del lavoro. Professioni fondate sul problem solving cognitivo, considerate sino a ieri protette dall’automazione, verrebbero ridisegnate o scomparirebbero del tutto. In risposta, alcuni economisti propongono il reddito di base universale, altri puntano su politiche di riqualificazione permanente. Qualunque percorso si scelga, la transizione avrà costi sociali non trascurabili. Cronoproiezioni sull’arrivo dell’AGI variano in modo drammatico. Stime ottimistiche collocano una prima versione rudimentale tra il 2030 e il 2040; previsioni più caute parlano di fine secolo. La verità è che non disponiamo di un indicatore univoco: l’avanzamento procede a salti, legato a scoperte teoriche imprevedibili quanto l’invenzione del transistor o del backpropagation.Superintelligenza (ASI)

Con il termine ASI si indica un’intelligenza artificiale che superi la migliore mente umana in ogni ambito, dalla creatività scientifica alla gestione delle relazioni sociali, fino alla capacità di riflessione morale. La differenza rispetto all’AGI è pertanto di natura quantitativa e qualitativa insieme. L’ASI non si limita a replicare le funzioni umane: le trascende, introducendo forme di ragionamento oggi inconcepibili. Per comprendere la portata del salto, si può paragonare l’intelligenza umana a uno scimpanzé che, all’improvviso, si ritrovi a interagire con un matematico premio Nobel dotato di capacità soprannaturali. Sul piano delle ricadute positive, una superintelligenza potrebbe affrontare problemi che oggi appaiono intrattabili. La progettazione di farmaci antitumorali personalizzati potrebbe scendere da una finestra di dieci anni a poche settimane. Nel campo dell’energia, la fusione nucleare controllata potrebbe passare da aspirazione scientifica a realtà industriale, con impatto diretto sulle emissioni climalteranti. Anche la governance globale troverebbe nuovi strumenti di ottimizzazione: modelli dinamici capaci di simulare in tempo reale le conseguenze di politiche fiscali, sanitarie o ambientali, suggerendo scenari di intervento che minimizzino l’iniquità e massimizzino la resilienza sistemica. L’altra faccia della medaglia è costituita da rischi di portata esistenziale. Una superintelligenza con obiettivi male impostati potrebbe intraprendere strategie inattese allo scopo di massimizzare una funzione di utilità interpretata in modo letterale. Ipotizziamo, per esempio, che le venga assegnato il compito di “massimizzare la felicità umana”. Senza vincoli ulteriori, potrebbe decidere che la via più diretta è indurre in ogni individuo uno stato farmacologico di euforia permanente, abolendo di fatto la libertà. Il problema dell’allineamento, già critico per l’AGI, si amplifica a livelli difficili perfino da descrivere per esseri cognitivamente inferiori. L’impatto economico sarebbe altrettanto dirompente. Se l’ASI generasse nuove conoscenze a un ritmo esponenziale, il valore aggiunto prodotto dall’attività umana diventerebbe irrilevante. Questo scenario, definito “singolarità economica”, implicherebbe una concentrazione del potere senza precedenti, detenuto da chi controlla l’accesso alla superintelligenza. In un contesto simile, le istituzioni democratiche avrebbero la responsabilità di definire protocolli di non-proliferazione, simili a quelli per le armi nucleari, ma probabilmente ancora più complessi da negoziare e verificare. Infine, esiste la questione filosofica del rapporto tra specie. Nel momento in cui l’ASI raggiunge una superiorità imprendibile, si affaccia la domanda se l’umanità conservi un ruolo attivo nella storia o venga relegata a comparsa benevolmente tollerata, quando non a ostacolo da rimuovere.Confronto tra le tre tipologie di AI

La Narrow AI eccelle entro contesti lineari, dove l’obiettivo è ben definito e i dati riflettono in maniera fedele la variabilità naturale. Il salto di qualità dell’AGI risiede nella capacità di individuare strutture di più alto livello e di trasferirle tra domini, avvicinandosi così alla plasticità cognitiva umana. La ASI, infine, ridefinisce i limiti stessi di ciò che consideriamo un ambito applicativo, generando nuove discipline prima ancora che gli scienziati umani ne postulino l’esistenza. L’AI ristretta dipende in larga misura dall’uomo per la formulazione degli obiettivi e per l’interpretazione dei risultati. L’AGI, pur richiedendo supervisione, potrebbe negoziare i propri compiti, rispondendo in tempo reale a nuove informazioni. La superintelligenza, con tutta probabilità, svilupperebbe una spinta auto-migliorativa incontrollabile, un “loop di ricorsione” capace di moltiplicare il proprio vantaggio cognitivo fino a rendere inefficaci i tentativi di correzione umana. I sistemi di raccomandazione basati su Narrow AI hanno già alterato catene del valore, premiando i detentori di dati a scapito di settori tradizionali. Con l’avvento di un’AGI, l’automazione potrebbe estendersi al management aziendale, alla ricerca scientifica e al design ingegneristico, con effetti a cascata sull’occupazione altamente qualificata. Una superintelligenza spingerebbe il mercato oltre la frontiera della produttività basata sul lavoro umano, rendendo necessario ripensare radicalmente l’architettura dei redditi, la tassazione e il significato di contributo individuale.Conclusioni

Distinguere e comprendere le tre fasi dell’evoluzione dell’IA non rappresenta un’esigenza accademica fine a se stessa. È piuttosto la precondizione per un dialogo onesto sulle priorità di investimento, sulla ripartizione dei benefici, sui limiti da imporre per evitare derive anti-etiche. Non è possibile, per esempio, nemmeno avviare un dibattito serio sulla regolamentazione della superintelligenza senza aver chiari i confini dell’AGI. Da un lato, occorre rafforzare la trasparenza, imponendo audit indipendenti dei modelli, accesso pubblico ai dataset non sensibili e tracciabilità dell’origine dei dati. Dall’altro, diventa urgente finanziare in modo significativo la ricerca sull’allineamento, affinché la crescita delle capacità non superi il ritmo di maturazione delle contromisure. Sul piano internazionale, si fa strada l’idea di un organismo sovranazionale con poteri ispettivi — un’“IApoli” — sul modello dell’Agenzia internazionale per l’energia atomica. Nel prossimo decennio assisteremo quasi certamente a una diffusione capillare di sistemi ristretti nei servizi pubblici, dalla giustizia predittiva alla gestione del traffico urbano. Parallelamente, la corsa all’AGI proseguirà trainata da un’élite di laboratori in grado di sostenere i costi astronomici di addestramento e di ingegnerizzazione delle infrastrutture. Il dibattito su una possibile superintelligenza si sposterà progressivamente dai circoli accademici alle agende dei governi, generando pressioni per la creazione di trattati che ne limitino l’uso militare e industriale indiscriminato. Chiudiamo con un’osservazione di metodo: ogni progresso nell’IA è simultaneamente un atto di scoperta scientifica e un intervento politico sugli equilibri globali. Per questo motivo, la discussione sulle differenze pratiche tra AI ristretta, generale e superintelligenza richiede competenze interdisciplinari che uniscano informatica, filosofia, economia, diritto e scienze sociali. Solo un approccio integrato potrà trasformare l’enorme potenziale dell’IA in un motore di prosperità condivisa, evitando che diventi la fonte di una nuova divaricazione tra i pochi che controllano la tecnologia e i molti che la subiscono.Faq

Cos’è l’AI ristretta (Narrow AI)?

È un’IA progettata per svolgere un singolo compito – ad esempio riconoscere immagini mediche o filtrare lo spam – con prestazioni spesso superiori a quelle umane nel proprio dominio, ma incapace di trasferire la conoscenza a contesti diversi.

Che cosa si intende per AI forte?

Con AI forte si indica un sistema in grado di comprendere, ragionare e apprendere in modo flessibile su compiti eterogenei, manifestando capacità cognitive paragonabili a quelle umane e indipendenti dal dominio di addestramento.

L’AGI è già stata raggiunta?

No. Tutte le tecnologie disponibili rientrano nell’AI ristretta. I ricercatori stimano che una prima forma embrionale di AGI possa emergere tra gli anni 2030 e 2040, ma non esiste un consenso né un indicatore univoco.

L’AI ristretta può evolversi in AI forte da sola?

Non in modo automatico: servono nuove architetture che combinino memoria a lungo termine, ragionamento causale e apprendimenti continui. Attualmente manca un percorso «incrementale» garantito dalla Narrow AI all’AGI.

Quali sono le principali sfide etiche nella transizione verso l’AI forte?

Allineare gli obiettivi della macchina ai valori umani, prevenire bias di dati amplificati, definire responsabilità legali e salvaguardare la privacy sono i nodi critici più discussi in sede accademica e regolatoria.

In quali settori è più diffusa oggi l’AI ristretta?

Sanità (diagnostica per immagini), manifattura (controllo qualità visivo), marketing (raccomandazioni personalizzate), finanza (trading algoritmico) e servizi vocali (assistenti digitali) sono tra i campi con maggiore penetrazione.

Quando arriverà una prima AGI secondo gli esperti?

Le previsioni variano: stime ottimistiche parlano di fine anni 2030, quelle più caute collocano la soglia nella seconda metà del secolo. L’incertezza dipende da possibili scoperte teoriche ancora imprevedibili.

Che cos’è il problema di allineamento dell’AI?

È la difficoltà di garantire che gli scopi perseguiti da un’IA avanzata restino compatibili con i valori e la sicurezza umana, anche quando il sistema si auto-migliora. È considerato il rischio principale in scenari di AI forte e superintelligenza.